本記事は、AI研究の第一人者としてGoogleで働いていたジェフリー・ヒントン(Geoffrey Hinton)氏が懸念するAIのリスクを3つ紹介。

海外メディアのインタビューでの発言などを筆者が補足しています。

2018年、ヒントン博士は、ニューラルネットワークの研究で、「コンピューティングのノーベル賞」とも呼ばれるチューリング賞を受賞。AI研究の第一人者と言われています。

| 投稿日 | 参照記事 |

|---|---|

| 2023年5月1日 | ‘The Godfather of AI’ Quits Google and Warns of Danger Ahead – The New York Times |

| 2023年5月2日 | AI ‘godfather’ Geoffrey Hinton warns of dangers as he quits Google – BBC News |

AI研究の第一人者ジェフリー・ヒントン氏が懸念するAIのリスク3つ

I want to talk about which is the existential risk of what happens when these things get more intelligent than us.

「私が話したい別の特定のことは、これらが私たちよりも知的になったときに何が起こるかという実存的リスクです」

※実存的リスクとは存在そのものに起因するリスク

とBBCへのインタビューで回答したと報道されています。

AI研究の第一人者ジェフリー・ヒントン氏が懸念するAIのリスクは下記の3つです。

- 偽の写真や動画、テキストが溢れ、何が真実かわからなくなる

- A.I.技術がやがて雇用市場を根底から覆す

- 真に自律的な兵器ロボットが現実のものとなる

それぞれ詳しく紹介。補足していきます。

1.偽の写真や動画、テキストが溢れ、何が真実かわからなくなるリスク

ジェフリー・ヒントン氏は、当面の懸念として、インターネット上に偽の写真や動画、テキストが溢れ、一般人が何が真実かわからなくなることを懸念しています。

筆者による補足

- AI生成の誤った情報の拡散

- フェイク動画の拡散

により、真実を見極めるのが難しくなる可能性は多くのメディアで指摘されています。

最近だと、全米大統領トランプ氏が逮捕されるフェイク画像がSNSに出回り騒ぎとなりました。

複数のメディアを確認する人は「これが事実かどうか」判断することができますが、その画像を見ただけで確認をしない人は、間違った情報をさらに拡散する可能性があります。

こういったことが日常茶飯事になると、一般人は何が真実か判断するのが困難になる可能性があります。

2.A.I.技術がやがて雇用市場を根底から覆すリスク

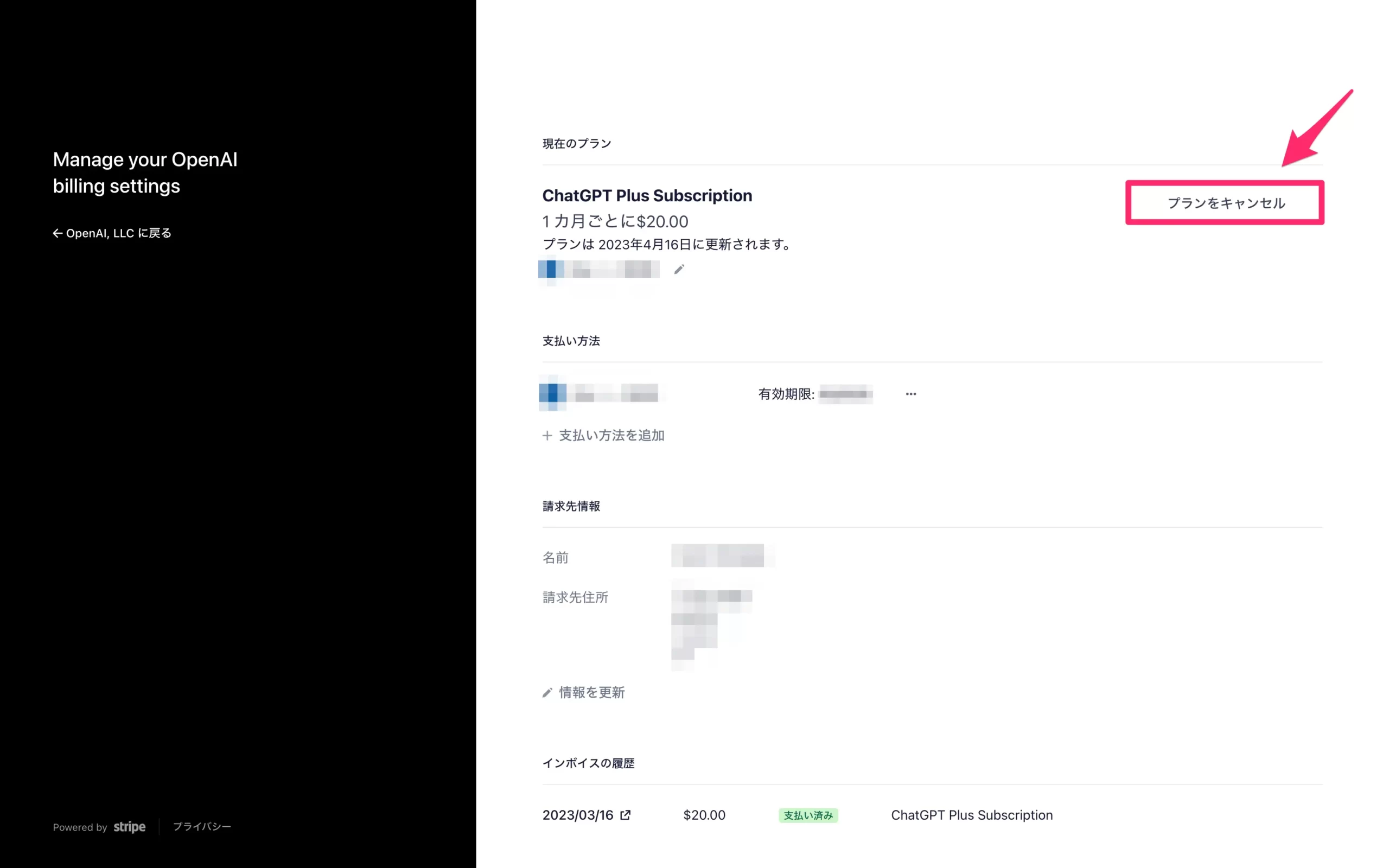

現在、ChatGPTのようなチャットボットは人間の労働者を補完する傾向にあるが、

- 法律事務員(パラリーガル)

- 個人秘書(パーソナルアシスタント)

- 翻訳者

など定型的な仕事をこなす人に取って代わることをジェフリー・ヒントン氏は懸念しています。

筆者による補足

中国では画像生成AIの影響でイラストレーターの失業が増加したと報道されています。

また、野村総合研究所の報告によると、日本の労働人口の 49%が人工知能やロボット等で代替可能になると試算されています。

しかし、AIの普及で失業者がどの程度増えるかは、実際のところ分かりません。

3.真に自律的な兵器ロボットが現実のものとなるリスク

この先、AIが膨大な量のデータを分析した結果、予期せぬ行動を学習することが多いため、未来のバージョンの技術が人類に脅威を与えることをジェフリー・ヒントン氏は懸念。

「このことは、個人や企業がA.I.システムに独自のコンピューターコードを生成させるだけでなく、実際にそのコードを実行させるようになると、問題になってくる」

と同氏は主張しています。

筆者による補足

筆者が調べた限りでは、自律的な兵器に明確な定義や規制はありません。

自律兵器の現状については、拓殖大学教授である佐藤丙午氏が解説しています。

2021年3月リビアでAIを搭載したドローンが攻撃で使われた可能性が海外メディアなどで報道されていますが、事実かどうかは分かっていません。

AI研究の第一人者がGoogleを退職し語った内容

75歳のジェフリー・ヒントン氏は、ニューヨークタイムズへの声明で Google を辞任したことを発表。

ヒントン博士がA.I.の先駆者から破滅論者になったことは、この数十年で最も重要な転換点にあるテクノロジー産業にとって、驚くべき瞬間である。

とニューヨークタイムズは報道しています。

以下は、彼の発言をまとめたものです。

悪者が悪事に利用するのを防ぐ方法は、なかなか見当たらない

先週、トロントの自宅のダイニングルームで行われた長いインタビューの中で、ヒントン博士は

“I console myself with the normal excuse: If I hadn’t done it, somebody else would have.”

“It is hard to see how you can prevent the bad actors from using it for bad things,”

「私はいつもの言い訳で自分を慰めます。私がやらなければ、他の誰かがやっただろう」

「悪者が悪事に利用するのを防ぐ方法は、なかなか見当たりません」

と語ったとニューヨークタイムズの記事で紹介されています。

ジェフリー・ヒントン氏は先月、会社に退職を通告し、木曜日にはグーグルの親会社であるアルファベットの最高経営責任者であるサンダー・ピチャイと電話で話をしましたが、同氏はピチャイ氏との会話の詳細について公にすることを避けたとのこと。

サンダー・ピチャイ氏は、他の技術もライフサイクルの早い段階で心配する人が増えているのを見てきたことから、AIについて楽観的に考えていると過去に発言しているため、同氏との考え方が異なります。

AIは人間の雑務を奪う

「雑務を奪う」

「それ以上のことをやってのけるかもしれない」

巨大なテクノロジー企業は、止めることのできない競争を繰り広げている

“Look at how it was five years ago and how it is now,”

“Take the difference and propagate it forwards. That’s scary.”

「5年前と現在を比べてみてください」

「5年前と今を比べて、その違いを前面に押し出していく。それは恐ろしいことだ」

The tech giants are locked in a competition that might be impossible to stop

「巨大なテクノロジー企業は、止めることのできない競争を繰り広げているのです」

と語りました。

Open AIのChat GPTが登場したことで競争が激化したことは明らかです。

人間より賢くなる

“The idea that this stuff could actually get smarter than people — a few people believed that,” he said. “But most people thought it was way off. And I thought it was way off. I thought it was 30 to 50 years or even longer away. Obviously, I no longer think that.”

「このようなものが実際に人間よりも賢くなれるという考え方は、少数の人は信じていました」

「しかし、ほとんどの人は、そんなことはあり得ないと思っていました。私もそう思っていました。30~50年、あるいはそれ以上先の話だと思っていました。明らかに、私はもうそう思っていません」

世界的に規制するのは不可能かもしれない

ヒントン博士は、テクノロジー企業が競争が世界的な競争に発展し、何らかの世界的な規制がなければ止まらなくなると考えていますが、

But that may be impossible

「しかし、それは不可能かもしれない」

と語っています。

here is no way of knowing whether companies or countries are working on the technology in secret.

「核兵器と違って、企業や国が秘密裏に技術開発を進めているかどうかを知る術はない」

ジェフリー・ヒントン氏、発言の解釈について補足

ジェフリー・ヒントン氏はTwitterで自身の発言について補足しています。

Googleは非常に責任ある行動をとってきた

2023年5月1日、以下の発言をしています。

In the NYT today, Cade Metz implies that I left Google so that I could criticize Google. Actually, I left so that I could talk about the dangers of AI without considering how this impacts Google. Google has acted very responsibly.

今日のNYTで、ケイド・メッツ※は、私がGoogleを批判するためにGoogleを辞めたとほざいている。実際、私は、AIがグーグルに与える影響を考慮することなく、その危険性について語ることができるようになるために、退職したのです。Googleは非常に責任ある行動をとってきました。

出典:Twitter

※ケイド・メッツ氏は、ニューヨーク・タイムズのテクノロジー記者

Googleを批判するために退職したわけではない

続けて、ベンチャーキャピタリストのスピロス・マルガリス氏(Spiros Margaris)との対話で

Maybe I over-reacted. When I read it I thought it could easily be interpreted as implying that I left so that I could criticize Google and that is certainly not the case.

「多分私は過剰に反応しました」

「私がそれを読んだとき、Google を批判するために退職したことを暗示していると簡単に解釈できると思いましたが、決してそうではありません」

と発言しています。

ジェフリー・ヒントン氏、BBCのインタビューでの発言

以下、BBCのインタビューでの発言から抜粋したものです。

私たちよりも知的なものが制御する

The issue is now that we’ve discovered it works better than we expected a few years ago.

「問題は、数年前に予想していたよりもうまく機能することを発見したことです」

What do we do to mitigate the long-term risks.

「長期的なリスクを軽減するために私たちは何をしますか」

Things more intelligent than us taking control.

「私たちよりも知的なものが制御する」

悪役についてはあまり心配していない

Let’s talk about those risks because you said that you’re worried about Bad actors what worries you the most about what could be used with this technology.

「悪役について心配しているとおっしゃっていたので、これらのリスクについてお話しましょう」

とBBCのインタビューに対して

権威主義の指導者が効果的なスパムボットをたくさん作ることができる

Service a lot of things a lot of other people have talked about to do with being able to produce lots of fake lots of text automatically so you can get lots of very effective spam Bots.

It’ll allow authoritarian leaders to manipulate their electrics things like that.

他の多くの人が話しているように、たくさんの偽のテキストを自動的に作成できるようにすることで、非常に効果的なスパムボットをたくさん作ることができ、権威主義の指導者が電気を操作することができるようになります。

と発言。

ニューヨークタイムズの記事の中で、AIを悪いことに使おうとする悪役に言及していたことについてBBCが詳しく聞くと

「これは一種の最悪のシナリオであり、一種の悪夢のシナリオです」

と答えた報道されています。

私たちが開発している種類の知能は、生物学的システムが持っている知能とは大きく異なる

So quite recently I come to the conclusion that the kind of intelligence we’re developing is very different from the intelligence we have we biological systems and the big difference is that with digital systems you have many copies of the same set of Weights the same model of the world and all these copies can learn separately but share their knowledge instantly if you had 10,000 people.

「 ごく最近、私たちが開発している種類の知能は、生物学的システムが持っている知能とは大きく異なるという結論に達しました。」

「大きな違いは、デジタル システムでは、同じモデルの同じ重みのセットの多くのコピーがあることです。 これらすべてのコピーは個別に学習できますが、10,000 人がいる場合、知識を即座に共有できます。」

とBBCのインタビューで語っています。

※本記事の内容は、記事執筆者の見解を示すものではありません。