2023年3月29日、米国のニュース情報誌タイム誌は、テスラやSpaceXの創設者であるイーロン・マスク氏が、AI開発の進展に関するオープンレターを発表したと記事で伝えました。

本記事では、タイム誌が伝えた内容を翻訳し補足、なぜこのような事態になったか解説しています。

※引用は英語を翻訳したもの

AIについてテック界の著名人が「深刻なリスクをもたらす」と規制を求める

イーロン・マスクを含む何百ものテック界の著名人の署名が入った公開書簡は、世界をリードする人工知能研究所に対し、新しい超強力なシステムのトレーニングを 6 か月間一時停止するよう促し、AI の最近の進歩は「深刻なリスクをもたらす」と述べています。

参照:AI Labs Urged to Pump the Brakes in Open Letter | Time

以下、記事を箇条書きで要約したものです。

- OpenAI の GPT-4 が公開されてからわずか2週間後に書簡が届く

- 多くの専門家は、AI の軍拡競争が過熱するにつれて、人類が夢遊病に陥り、大惨事に陥っていると懸念

- すべてのAIラボに対し、提案された 6 か月の一時停止を使用して安全性研究を継続することに同意するよう求める

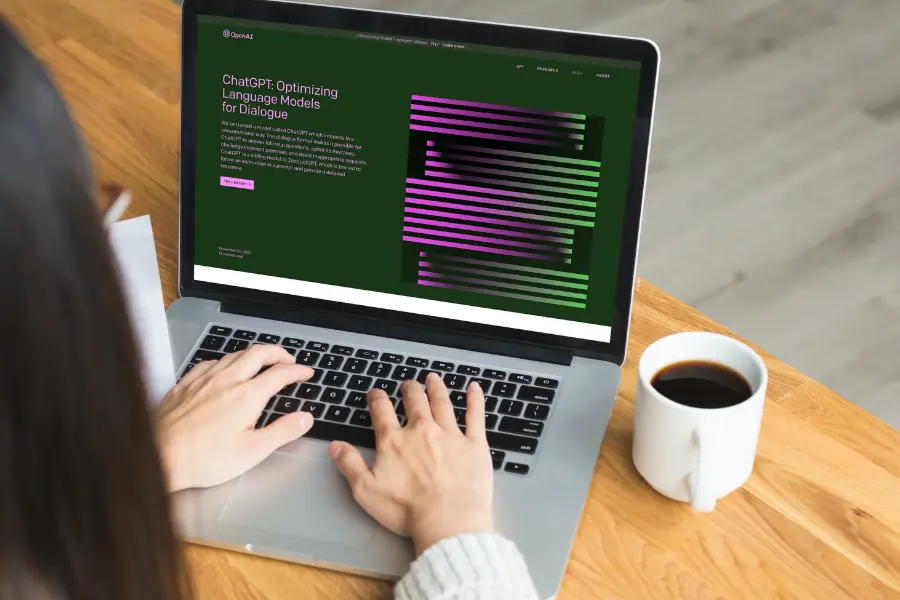

※Open AIは、会話ができるAIで話題のChat GPTを提供する人工知能研究所

「高度な AI は、地球上の生命の歴史に大きな変化をもたらす可能性があり、相応の注意とリソースを使って計画し、管理する必要があります」

と公開書簡に記載されているとのこと。

追記:3月30日、公開書簡をFuture of Life Institute(英語)で確認したところ、下記記述がありました。

私たちはすべての AI ラボに対し、GPT-4 よりも強力な AI システムのトレーニングを少なくとも 6 か月間直ちに一時停止するよう呼びかけます。

つまり、「現状(GPT-4)よりも強力なAIシステムのトレーニングを一時停止しろ」という内容です。

署名者のリスト(一部)

米国のニュース情報誌タイム は、下記の人物の名前を挙げています。

- イーロン・マスク

- Apple の共同創設者であるスティーブ ウォズニアック

- サピエンスの著者であるユヴァル ノア ハラリ

- 機械学習の複数のブレークスルーに貢献したAIの最も著名な学者など、900 人以上の名前が含まれています。

- 子会社のAIラボ DeepMindの3 人

- Stability AIのCEOであるEmad Mostaque

- Center for Humane Technologyのエグゼクティブ ディレクターである Tristan Harris

- 少なくとも 4 人のGoogle従業員

※敬称略

※すべての署名が本物であることは確認できなかったと記載

4月1日時点で、2,300名近くの署名が集まっています。

しかし、公開書簡に偽の署名者が多数まぎれていたことが、Yann LeCun氏の発言で明らかになりました。

いいえ。

私はこの手紙に署名していません。

私はその前提に同意しません。

リストは下記リンクから確認できます。

Pause Giant AI Experiments: An Open Letter – Future of Life Institute

なぜこのような事態になったか?

なぜAIは急速に普及し規制される動きとなったか?

ポイントとなるのは下記4点です。

- 期せずして「ヨーイドン」が起きた

- 著作権・プライバシーの問題

- AIに仕事が奪われる恐怖

- 長期的なリスク・開発者のシステム理解

期せずして「ヨーイドン」が起きた

開発元のOpen AIは「想定以上に早かった」と紹介。

また「わずか数ヶ月で1億人以上の人が使う状況になり、Chat GPTのような機能を持つ可能性に人々が一瞬にして気付いた」

「これはやばい」「これは色んなことが起きる」と人々が信じ、「期せずしてヨーイドンが起きた」と東京大学大学院工学系研究科、松尾豊教授が上記動画内で紹介しています。

著作権・プライバシーの問題

また、現在、AIの急激な浸透により世界中で著作権、プライバシーなど様々な問題が起きていることが一つの原因だと考えられます。

AIに仕事が奪われる恐怖

また、多くの人々が「AIに仕事が奪われる」と不安に感じています。

過去には、産業革命などで同じようなことが起きましたが、AIはあらゆる仕事を代替することができます。

筆者は、「50%以上の仕事がAIに置き換わる」という話を数学者、新井紀子氏の書籍で解説されているのを読みました。

(正確に言うと、Amazonオーディブルで散歩をしながら聞きました。)

当時の本では、AGI(本当の人工知能)はまだまだ先の話と言われていましたが、今人々が熱狂している状況は想定外だったのではないでしょうか。

長期的なリスクがありシステム発明者でさえシステムを正確に理解していない

話はタイム誌の内容に戻ります。

Rebooting AIの著者であるGary Marcus氏は、タイム誌に以下のように語っています。

「深刻な短期的および長期的なリスクがあり、企業のAIの責任は、人類がそれを最も必要としているときに流行を失ったようです」

また、AI 安全スタートアップ SaferAIのCEO であるSimeon Campos氏も以下のようにタイム誌で述べています。

システムの発明者でさえ、システムがどのように機能するかを正確に理解していない場合、システムのリスクを管理することは不可能であるため、書簡に署名した

AIは様々なデータから学習し、回答を文脈に合わせて出力するため、開発者も完全に制御することができません。

手放しで「便利だし最高」とはいかない理由がここにあります。

AIとは?AGIとの違い

AI(人工知能、Artificial Intelligence)は、コンピューターシステムが人間の知的タスクを模倣し実行する能力を持つ技術の総称です。

例えば、音声認識システムは、Siriやアレクサのように音声をテキストに変換し、人間とコミュニケーションを取る能力を持ちます。

一方、一般的に人間にとって恐れられているのはAGI(人工一般知能)です。

これは、人間の知能に匹敵するレベルで幅広い知識やタスクを実行できるAIシステムを一般に指します。AGIの実現は非常に困難とされていましたが、AIの急速な発達によりリスクについて多くの専門家が言及しています。

※9月15日:更新

関連記事

-

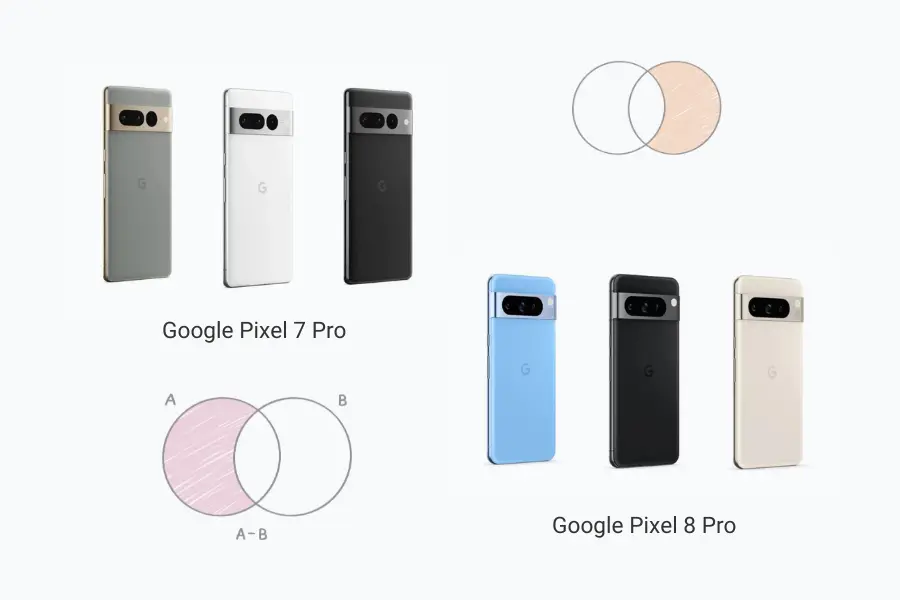

「Google Pixel 8」が10月12日発売!搭載されているAI機能

-

【速報】Chat GPT 日本語版で利用可能な「アルファ」がスタート

-

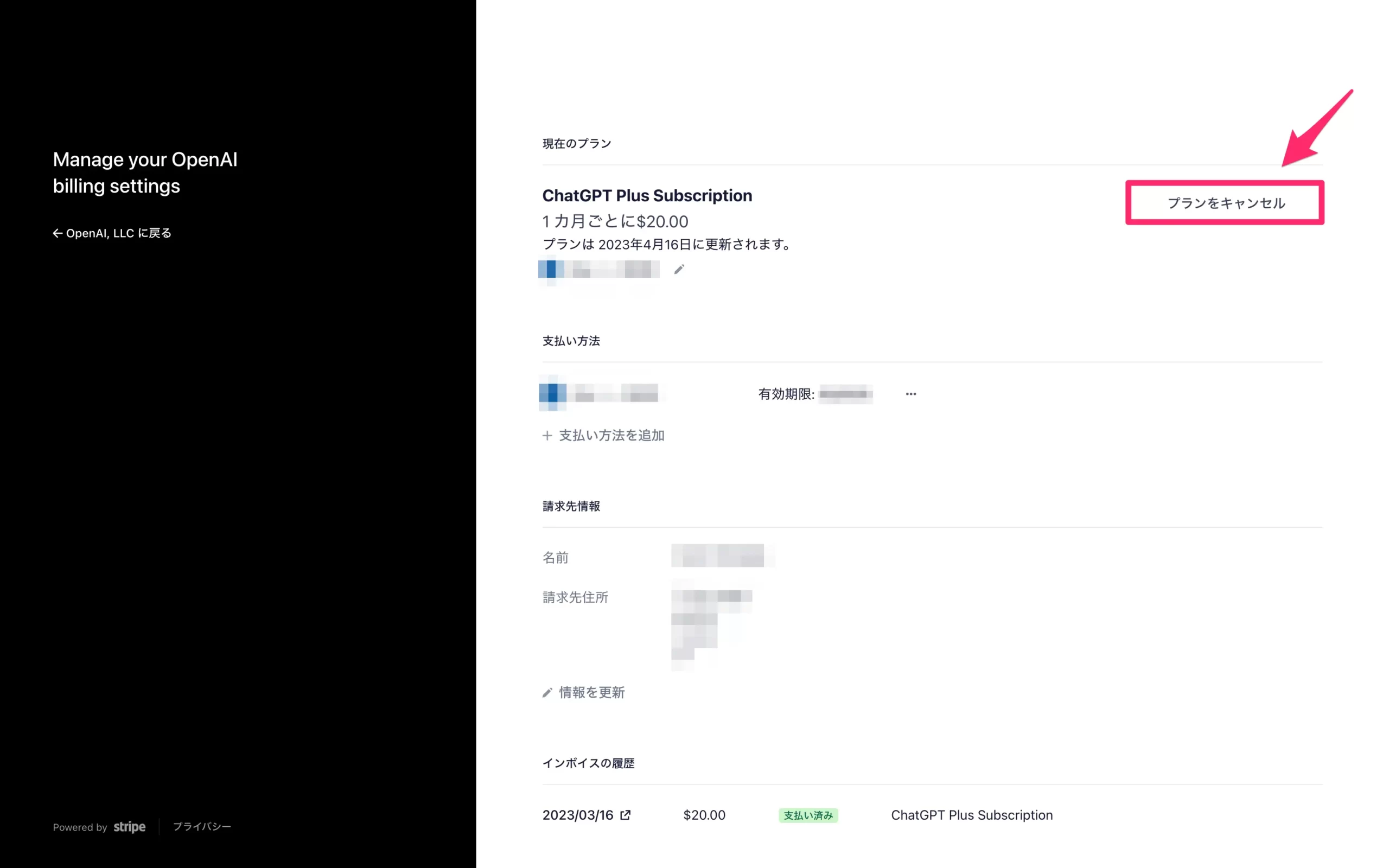

Chat GPTの使い方を分かりやすく解説!利用する際の注意点5つ

-

Google Bard の最新機能![G]ボタンとは?使い方を解説

-

機能が豊富!AIいらすとやレビュー。率直な感想7つ

-

Adobeの生成AI「Adobe Firefly」の料金プランと機能を解説

-

Google 検索で生成AIを使うには?SGE利用に必要なものと利用手順

-

AIに「人間とは何か」聞いてみた。回答から考察

-

簡単!Canva のAI画像生成ツールを使ってみた率直な感想5つ